Loi de Moore

Si vous êtes acteur du numérique, vous connaissez probablement la célèbre loi de Moore.

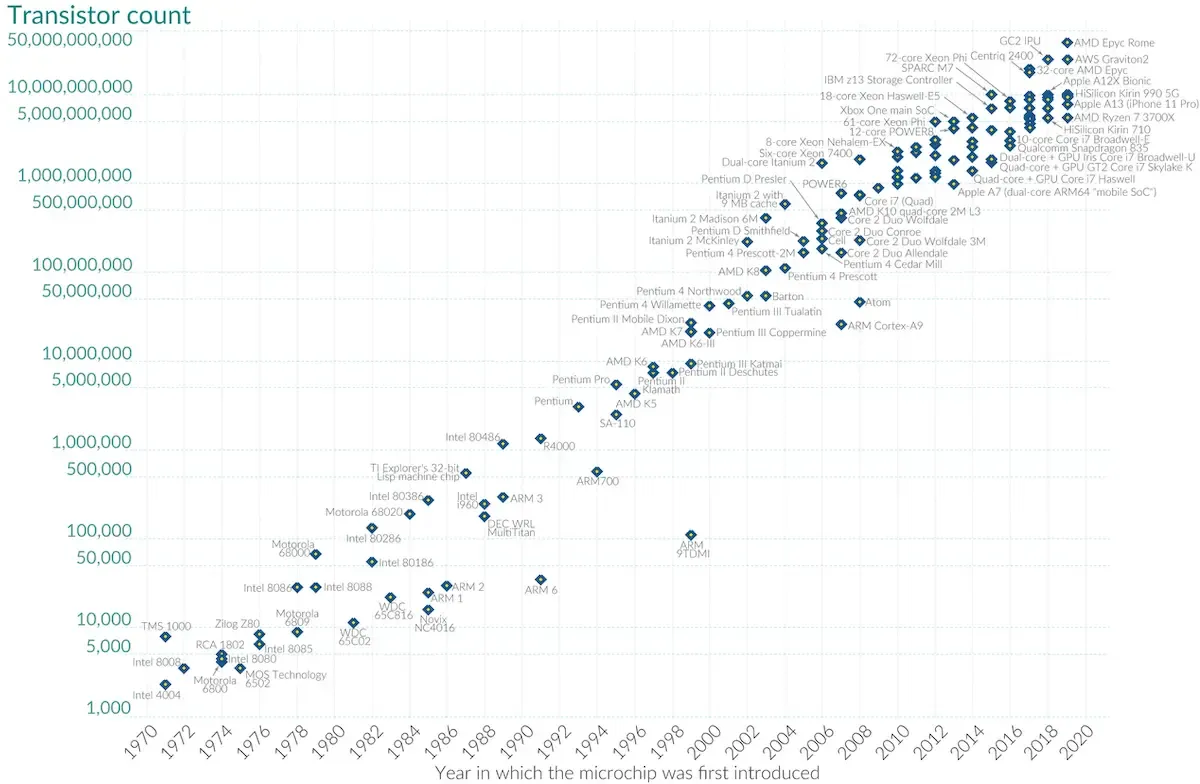

Petite piqûre de rappel pour ceux qui n’aurait pas fait leurs devoirs. Cette loi, formulée en 1965, prédit que la puissance de calcul de nos microprocesseurs est multipliée par deux tous les deux ans.

Concrètement, cela veut dire que nos ordinateurs sont deux fois plus rapides tous les deux ans.

Ce qui est fort, c’est que ce cher Moore à visé juste car ce phénomène a été observé depuis 1965.

Loi de Wirth

Bon, maintenant si je vous demande, qui connait la loi de Wirth ? Tout à coup je vois beaucoup moins de mains en l’air.

La loi de Wirth, qui prend le nom de son créateur Niklaus Wirth, est une loi empirique formulée en 1995 qui fait le constat suivant : “Les programmes ralentissent plus vite que le matériel n’accélère”.

Attends pause ! Si je comprends bien, ça veut dire qu’on a des ordinateurs qui ressemblent de plus en plus à des fusées SpaceX mais que je vais aussi vite que ma Clio 2 pour envoyer un message Teams ? (Je vous rassure il n’y a pas de collaboration commerciale ici)

C’est bien ça, si on combine les deux lois précédentes, on obtient des logiciels moins performants alors que le matériel l’est bien plus. C’est quand même dommage non ?

Dans cet article, nous allons voir d’où vient le problème, comment il se matérialise dans le domaine du Web et comment il est devenu une norme qui n’est pas soutenable sur du long terme.

L’âge d’or du microprocesseur

En effet, depuis l’invention du microprocesseur dans les années 70s, les ordinateurs sont devenus de plus en plus puissants (Loi de Moore).

Ce phénomène a permis à l’industrie du développement logiciel de bénéficier de ces capacités de calculs pour étoffer les logiciels, permettant ainsi d’offrir plus de fonctionnalités à leurs utilisateurs.

Quelle est la source du problème ?

La plupart du temps, le but d’une société est de générer de l’agent. Pour cela, elle va fournir un produit ou un service à un ensemble de client.

Dans l’industrie du logiciel, les sociétés développent des programmes permettant de résoudre les problèmes de leurs utilisateurs.

Si on veut faire plus d’argent, comment fait-on ?

La solution naturelle est la suivante : ajouter d’autres fonctionnalités. C’est ainsi qu’avec le temps, les logiciels sont devenus de plus en plus lourds et lents à exécuter sur nos machines.

On appelle ces logiciels des obésiciels faisant référence à l’obésité d’un logiciel.

Pourquoi a-t-on ce problème ?

Tous les deux ans, les ordinateurs sont deux fois plus puissants. Si aujourd’hui un logiciel est un peu trop lent et trop lourd pour les machines actuelles, il ne le sera plus du tout pour la génération suivante.

Alors, pourquoi dépenser de l’argent à optimiser les logiciels afin qu’ils soient moins gourmands en mémoire et en calcul si dans quelques mois tout cela ne se fera plus ressentir à l’usage ?

Comme on dit, business is business. C’est ainsi que l’industrie logicielle procède à une course effrénée en avant, sans se soucier d’où se trouve la ligne d’arrivée et quelles seront les conséquences.

Quelles sont les conséquences de la loi de Wirth ?

Obsolescence logicielle

Les obésiciels, même s’ils deviennent utilisables avec le temps, provoquent de l’obsolescence logicielle.

Ce phénomène entraîne un sentiment d’obsolescence du matériel chez les utilisateurs, ce qui les encourage à acheter la dernière génération des téléphones ou des ordinateurs pour obtenir un meilleur confort d’utilisation.

Ainsi, des millions d’ordinateurs, smartphones ou autres appareils sont jetés car jugés “trop lents”. Le problème ne vient pas du matériel mais plutôt du logiciel qui tourne dessus.

Cela à un impact considérable sur l’environnement lorsqu’on sait qu’il faudrait garder son matériel le plus longtemps possible. En effet, la construction d’un smartphone représente 90% de l’empreinte carbone de son cycle de vie et ce chiffre est de 70% pour un ordinateur.

Limitation des ressources naturels

La conséquence la plus critique est l’épuisement des ressources naturelles. Les ressources nécessaires pour la construction de matériel électronique se font de plus en plus rares, sont de plus en plus difficiles à extraire, demande une énergie toujours plus grande et provoque des pollutions toujours plus importantes.

On ne pourra pas produire indéfiniment des CPU. Pas de terres rares, pas de CPU, pas de CPU pas de calculs, pas de calculs pas de logiciels. Game over.

Qu’en est-il du web ?

Évolution du poids des pages web

Au début, les pages web ne comportaient que du texte et ne pesaient que quelques KB.

Entre 1990 et 2000, les pages ont commencé à utiliser un peu plus de CSS et de JavaScript augmentant la taille moyenne d’une page entre 100 et 200 KB.

S’en est suivie l’amélioration des réseaux permettant de transporter des médias de plus en plus lourds, ce qui a amené la taille moyenne des pages web à augmenter progressivement au rythme des capacités réseaux.

En 2024, selon HTTP Archive, une page web pèse en moyenne 2,4 MB. Cette taille peut monter au-dessus de 10MB pour les applications les plus complexes.

Il existe plusieurs raisons qui expliquent l’augmentation de la taille des pages web :

- contenu plus lourd (résolution des images / vidéos)

- poids des frameworks JavaScript

- utilisation de web font

- beaucoup de fonctionnalités sur une page

En 30 ans, le poids moyen d’une page web a été multiplié d’un facteur 100.

Prenons du recul sur ces chiffres. Est-ce que les pages web vont 100 fois plus vite ? Est-ce qu’on peut faire 100 fois plus de choses ?

La réponse, je vous la donne en mille, c’est non. Il faut avouer que les pages web sont beaucoup plus jolies, elles permettent plus de chose qu’en 1989, mais ça ne justifie en rien cette augmentation d’un facteur 100 du poids des pages.

Réseau Internet

Ce qui a viabilisé l’évolution de la taille des pages web, c’est l’évolution des réseaux.

Au début du web, on estime que la connexion moyenne dans le monde était de quelques dizaines de KB/s.

Aujourd’hui, cette moyenne est environ égale à 100MB/s, chiffre qui dépend des pays et de la maturité de leur infrastructure.

Globalement, depuis le début du web, le réseau internet est plus rapide d’un ordre de grandeur de 1000 et on estime que la vitesse d’Internet augmente de 20% par an dans le monde.

Et oui, imaginez charger une page internet moderne avec les réseaux des années 90. Je vous souhaite énormément de patience !

Le paradoxe de Jevons

L’effet rebond également connus sous le nom de paradoxe de Jevons, tire son nom de l’économiste William Stanley Jevons et se formule ainsi “plus les améliorations technologiques augmentent l’efficacité avec laquelle une ressource est employée, plus la consommation totale de cette ressource aura tendance à augmenter, au lieu de diminuer”.

En effet, même si les réseaux sont de plus en plus performants et tendent à consommer moins d’énergie pour la même quantité de données échangées, on observe que ces derniers suivent la tendance d’utilisation des usagers qui elle est croissante.

Ainsi, la capacité du réseau suit l’augmentation de la taille des pages web. On obtient donc des coûts énergétiques plus élevés et des vitesses de chargement de page qui ne s’améliorent pas.

Le coût de l’effet rebond

Si on constate que le réseau internet est de plus en plus rapide, on parle moins du coût écologique croissant de ce dernier.

Prenons comme exemple la dernière révolution réseau en date, la 5G. Comparé à son prédécesseur (le réseau 4G), le réseau 5G consomme moins d’énergie pour le transport d’une même quantité de données.

On pourrait se dire que c’est très bien, mais c’est ici qu’on assiste aux conséquences de l’effet rebond. Le premier coût provient de la fabrication et du déploiement du réseau en lui-même.

En effet, le réseau 5G s’appuie sur de nombreuses antennes réseau, qui malgré leur faible consommation, ont un impact écologique important provenant de leur construction.

De plus, ce nouveau réseau plus puissant offre de nouvelles possibilités en permettant de transporter des quantités de données plus importantes plus rapidement. Ces nouvelles possibilités induisent une production et consommation de beaucoup plus de données, entrainant une utilisation intensive du réseau.

On pourra citer l’avènement des plateformes de streaming qui augmentent les flux vidéo (Twitch, Youtube, Netflix,…) offrant des qualités de vidéo toujours plus grandes et plus lourdes.

Parfois, ces offres ne sont même pas utiles, car une vidéo en 4K sur un écran de téléphone n’apporte rien de plus à part une augmentation de la consommation de batterie du à la demande réseau importante pour charger cette dernière.

Au final, si on regarde en valeur absolue, les consommations d’énergie et de matériaux augmentent malgré les avancées techniques qui offrent des économies.

Le cercle vicieux

Depuis le début du web, nous avons de plus en plus de puissance de calcul et des réseaux de plus en plus performants.

Ainsi, l’évolution des pages web entraîne leur alourdissement demandant une bande passante de plus en plus élevée.

Les fournisseurs réseaux s’adaptent à cette nouvelle demande et augmente leur infrastructure ce qui provoque des coûts écologiques important lors de la mise en service des réseaux et lors de leur usage intensif.

Ces réseaux plus performants incitent à consommer plus de données, plus rapidement. De plus, ils permettent de nouveaux usages toujours plus demandant qui amène donc à un besoin d’amélioration du réseau.

Nous sommes dans une situation de l’oeuf ou de la poule. Est-ce que les nouveaux usages du Web force les appareils et les réseaux à évoluer pour satisfaire la demande ? Ou est-ce plutôt l’apparition de nouvelles capacités techniques qui créées des usages déraisonnables ?

Au final, on obtient un cercle vicieux sans fin qui alimente une augmentation de la consommation.

L’augmentation des capacités techniques entraîne de nouvelle possibilités d’usage mais posons-nous la question. Comment utilisons-nous ces nouvelles capacités ? Dans quel but ? Sont-elles vraiment nécessaires ?

L’objectif serait d’être dans un modèle de diminution de consommation de ressources à chaque évolution technique.

La ligne d’arrivée

La ligne d’arrivée, ou je dirais plutôt le mur, est matérialisé par la raréfaction des ressources nécessaires à la fabrication du matériel telles que les terres rares et l’eau douce.

Cette limite signera une rupture brutale dans l’utilisation du numérique en marquant une chute de notre puissance de calcul, car il ne sera plus possible de produire assez de composants permettant de calculer ou de stocker des données.

La sobriété numérique comme solution

Il existe une solution pour éviter ce scénario catastrophe : “faire moins et faire mieux”. Il ne faut pas s’empêcher de faire de l’optimisation par peur de l’effet rebond.

L’effet rebond n’est pas une fatalité. Les excès provoqués par les améliorations, viennent d’un manque de connaissances et de conscience de ce phénomène.

Pour cela, on peut adopter la démarche de sobriété numérique qui consiste à se questionner sur les usages du numérique. Le but est de réduire l’usage à ce qui est nécessaire et de ne pas surconsommer sans raison.

La sobriété numérique est l’une des clés pour solutionner le problème. Elle permet de poser les bonnes questions afin de raisonner les besoins :

- ai-je besoin de ce service ?

- ai-je besoin de plus de puissance de calcul ?

- ai-je besoin de remplacer mon ordinateur ?

- …

Toutes ces questions permettent d’atteindre une utilisation raisonnable du numérique.

Enseigner la sobriété numérique aux concepteurs, développeurs et consommateurs du numérique est un levier important pour permettre de diminuer l’impact écologique de ce dernier.

Conclusion

L’industrie numérique s’est développée autour de la loi de Moore, mais nous arrivons aux limites de cette dernière dues aux contraintes de la physique et à la raréfaction des matières premières pour la construction des composants.

Il devient important de construire l’avenir en prenant en compte la loi de Wirth afin de diminuer les impacts de cette loi qui entraine l’obsolescence logicielle et le changement prématuré des appareils.

L’optimisation et les améliorations techniques apportent de très bonnes solutions pour économiser des ressources, mais il faut prendre conscience de l’effet rebond.

L’optimisation est une partie importante de la démarche à mettre en oeuvre, mais ce n’est qu’une partie de la solution. Pour ne pas tomber dans les travers de l’effet rebond et surtout avoir un impact fort, il faut retourner à la base.

Posons-nous les bonnes questions sur la façon dont nous concevons et développons les services numériques et sur la façon dont nous les consommons.

La sobriété numérique est un schéma de pensée permettant de raisonner la consommation du numérique et limiter les impacts de ce dernier sur l’environnement. Il est temps de faire moins mais mieux. Les changements de comportement passent par la sensibilisation des acteurs du numérique et de leurs consommateurs.

Gardons en tête qu’en tant qu’acteurs du numérique, nous avons la plus grande part de responsabilité dans l’application des bonnes pratiques pour créer un numérique plus durable.

J’espère vous avoir donné l’envie d’éco-concevoir vos services numériques, que vous soyez UX, PO, chef de projet ou encore développeur.

Merci pour votre lecture et bonne journée ! 🌳☀️